![[レポート] Deeplens用に適切にDeepLearningモデルを調整する #AIM405 #reinvent](https://devio2023-media.developers.io/wp-content/uploads/2019/12/reinvent2019_report_eyecatch.jpg)

[レポート] Deeplens用に適切にDeepLearningモデルを調整する #AIM405 #reinvent

せーのでございます。

2019年12月02日〜2019年12月07日にかけてアメリカはラスベガスにてAWS最大のカンファレンス、AWS re:Invent 2019が開催されております。

クラメソチームは今年は80名という常軌を逸した人数で現地に乗り込んでおります。

このブログは下記ワークショップについてのレポートです。

AIM405 - Optimize deep learning models for edge deployments with AWS DeepLens Nathaniel Slater - Senior Manager, Amazon Web Services

Phu Nguyen - Product Manager, Amazon Web Services{セッション概要}

レポート

ワークショップ会場に入るとマシンは既にセットアップされていまして、様々な場所にくま、くま、くま。

DeepLensの横にも何故かくまのぬいぐるみが。

今回のワークショップはこのくまのぬいぐるみをDeepLensに写し、これが「しろくま」であることを機械学習で見分ける、というものです。

手順としては、まずSageMaker Ground Truthで教師データとなる画像にラベリングをし、その後データセットとなる2000枚近くの画像で学習、評価を行いモデルを生成、SageMaker NeoでDeepLens用にモデルを調整してデプロイ、最後に実際にくまのぬいぐるみを写して推論する、という流れになります。AWSを使った機械学習の基本的な要素が詰まっているワークショップですね。

まずはスピーカーのPhuさんよりAWSの機械学習についてのレクチャーがありました。

- 様々なサービスの形でAWSは機械学習を世に発表している

- Personalizeでは予測とフルフィルメントを予測することで電気や水の消費量を予測する

- AlexaやEchoグループのような自然言語処理技術からAmazon Pollyというサービスに転じさせることもできた

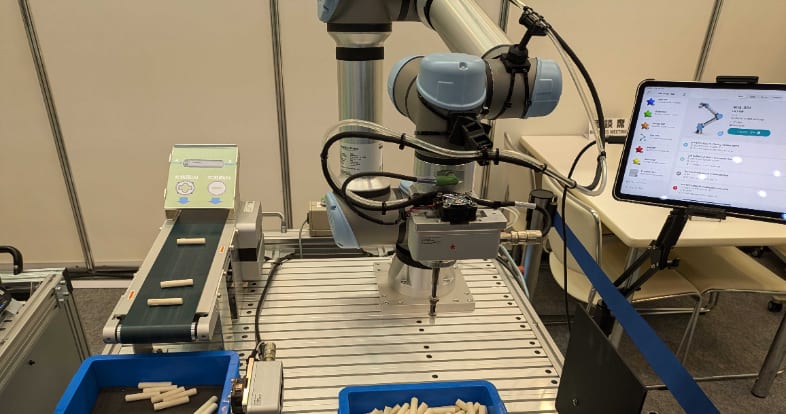

- Amazonの倉庫内には注文を処理するために10万台のロボットが稼働している

- AWSのミッションは機械学習の開発者を増やすこと

- そのために「機械学習ツールのDeepset」「SageMakerを使った機械学習の採用を加速すること」「アプリケーションとしてのAIサービス」という3つの方法を使う

- 2年前にDeepLensでコンピュータビジョンを、去年はDeepRacerで強化学習を、そして今年はDeepComposerでGANの勉強を支援する

それではいよいよワークショップです。

ワークショップは5つのステップに分かれていて

- SageMakerのセットアップ

- SageMaker Ground Truthを使ったDataSetのラベリング

- SageMakerを使ってカスタムモデルの学習

- DeepLensにカスタムモデルをデプロイ

- SageMaker Neoを使ってエッジデバイス用にモデルを調整

となります。

細かい手順はGithubとJupiter Notebookに上がっていまして、それを参考に進めていく形となります。

セットアップが終わったらくまの写真をダウンロードして

SageMaker Ground Truthでラベリング

今回は学習にMXNetのGluon CVを使います。

順調にいっていたのですがここで問題が。

なんとデプロイ用で使う予定のml.c4.xlargeインスタンスが上限に引っかかっていて使えない、とエラーが出てしまう事態に。

結局デプロイできずにここで終了、となってしまいました。

うーん、残念。

まとめ

使用したくまのぬいぐるみとDeepLensの割引券をもらって終了、となりました。2時間のワークショップでしたが、中身を理解しながら進んでいくとギリギリ2時間で終われるかどうか、というボリュームの内容でした。初めて機械学習を触る人はこういったワークショップを受けると大枠がつかめるようになって大変良いのではないでしょうか。

![[レポート] インシデント発生に備えるための議論をする tabletop「Incident response tabletop: Supply chain」 #GHJ205-R #AWSreInvent](https://images.ctfassets.net/ct0aopd36mqt/3IQLlbdUkRvu7Q2LupRW2o/edff8982184ea7cc2d5efa2ddd2915f5/reinvent-2024-sessionreport-jp.jpg)